Bei meinem zweiten Experiment, was die Vertonung von Bewegtbild angeht, handelt es sich um einen 120 Sekunden langen, ausschließlich aus 3D Renderings bestehenden Werbespot, welcher ein Hauswärme/Energiesystem der Firma KWB veranschaulicht und erklären soll, wie dieses funktioniert und arbeitet. Dieses Produkt der Firma KWB ist neu am Markt und bedarf daher eine verständliche Einführung für sowohl Interessenten als auch interne Mitarbeiter, die das System in weiterer Folge präsentieren und verkaufen werden.

Es handelt sich hierbei wieder um ein sehr technisches Produkt, das jedoch mit natürlichen Rohstoffen (Energie der Sonne/ Solarenergie) operiert und dadurch einen starken Zusammenhang mit Nachhaltigkeit / Unabhängigkeit suggeriert.

Die Bilder

Rein bildlich gesehen, ist der Werbespot relativ Hell, da der Fokus der Renderings hauptsächlich auf dem (weißen) Haus und der darin verbauten Technik liegt. Die gesamte Außenwelt belauft sich auf einen kleinen Rasen vor dem Haus, hält sich abgesehen davon mit weißen Flächen und einem hellen Himmel absolut steril.

Da die Schnitte des Videos ausschließlich in der Distanz springen – also näher an das Haus heranzoomen / die darin verbaute Technik durchleuchten – gibt es keine tatsächlichen Ortswechsel im Spot. Die gesamte Handlung spielt sich vor / mit / im Haus ab.

Die Wahl der Instrumente

Wenn man sich also die Frage stellt, wie bzw. mit welchen Instrumenten die Präsentation dieses Produktes am besten unterstützt werden kann, würden aus den oben genannten Gründen in erster Linie synthetische Klänge dazu passen, da sie ähnlich wie das Produkt von Menschenhand geschaffen und geformt wurden, um einen bestimmten Zweck oder Klang zu erfüllen.

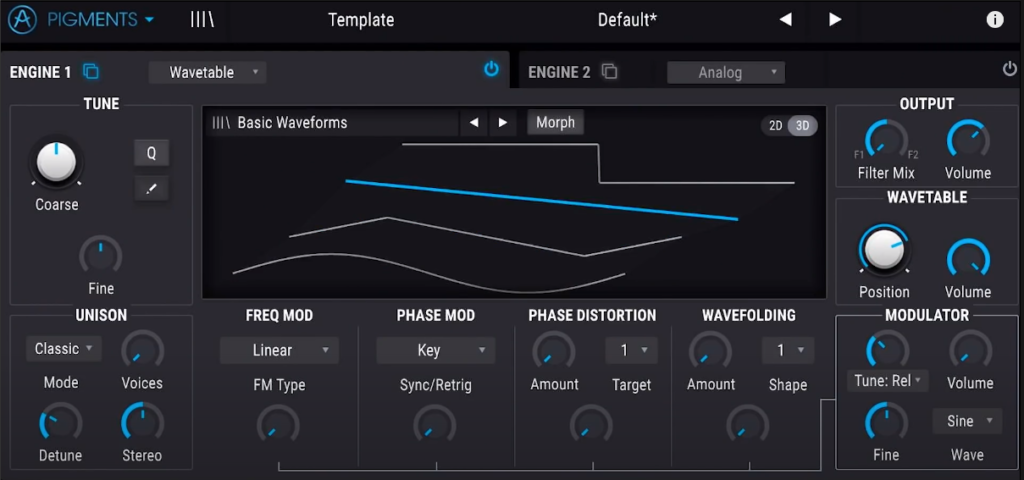

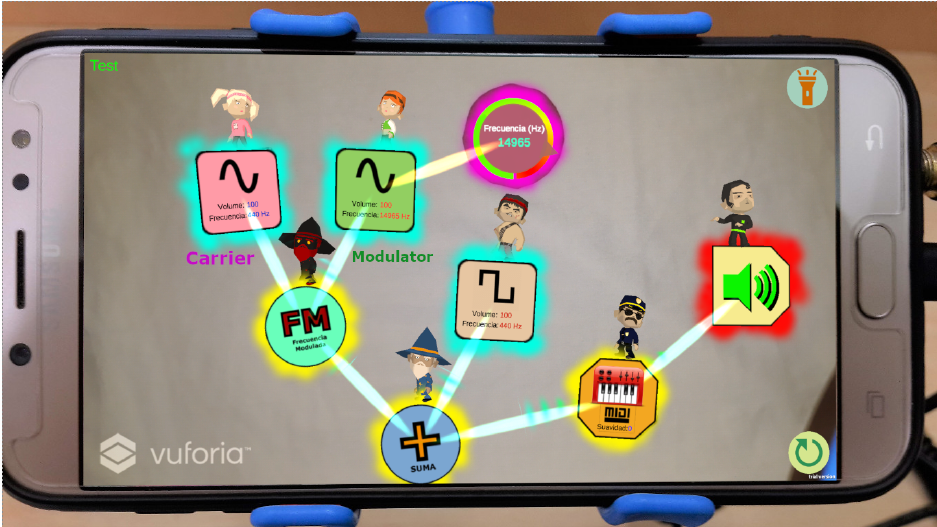

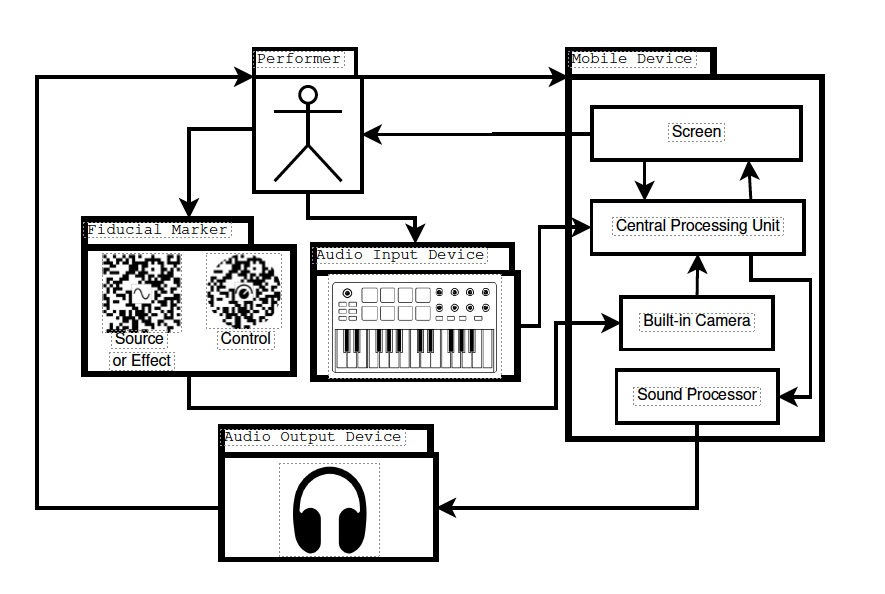

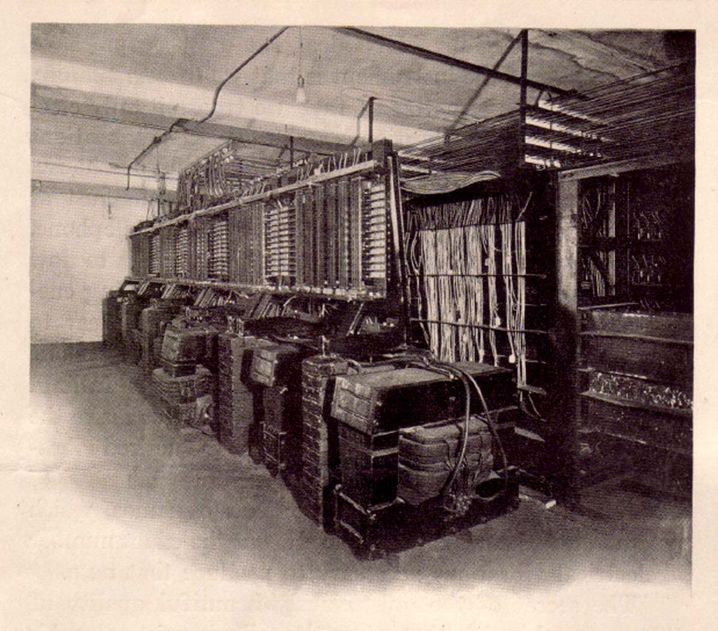

Synthesizer

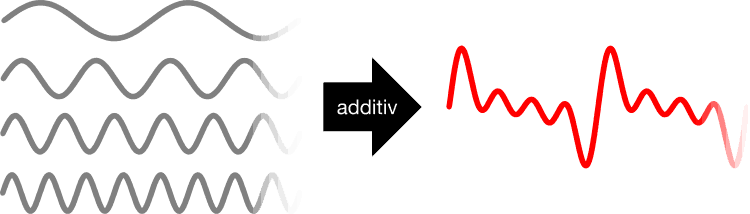

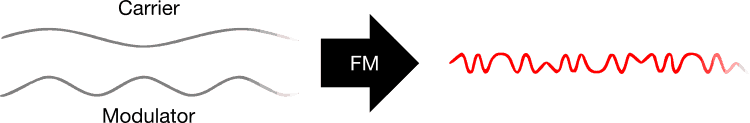

Nachdem es sich hier um keinen Realfilm, sondern ausschließlich um digital erzeugte Renderings handelt, liegt der Gedanken nahe, künstliche, digital erzeugte Klänge zu wählen. Denn auch wenn besagte Klänge durch Modulationen usw. so verändert werden können, dass sie sich entwickeln und bewegen (was meist unternommen wird um den Klängen „Leben einzuhauchen“) sind sie doch von einer digitalen / künstlichen Klangästhetik geprägt, die mit dem Thema Strom und Wärmeflüsse gut einhergeht.

Die Komposition (Interpretation und Beschreibung)

Die Komposition zeichnet sich durch ihre fließenden, großflächigen und ineinander übergehenden Sounds aus, die sich im Grunde auf ein paar wenige Akkorde in der Abfolge reduzieren lassen.

Nachdem das Video keine Geschichte erzählt, und dadurch keine klassische Storyline oder Handlung hat, macht es hier in meinem Ermessen wenig Sinn, eine nicht existierende Geschichte durch Musik zu erzählen. Der Fokus liegt viel mehr darauf, die durch einen Sprecher und den Animationen erklärten Inhalte musikalisch zu untermalen. Wenn man sich das Konzept des Energy Comfort Systems ansieht geht es darum, Wärme und Strom einzufangen, im Haus zu verteilen und wenn kein Bedarf besteht zu speichern.

Demnach macht es Sinn, sich mit ebenfalls warmen Klängen auseinanderzusetzen und diese in die Komposition zu integrieren.

Nachdem die anfänglich leichten, mit rückwärts abgespielten Artefakten verzierten Sounds, die die Sonne in ihrem Wesen beschreiben sollen erklingen, stoßt bei etwa Sekunde 20 ein tiefer, anschwellender Sound dazu, der die Wärme darstellen soll. Der Kreislauf des Hauses wird durch die Solar Platten aktiviert und der ewige Zyklus von Energieaufnahme und Verteilung beginnt.

Die Klangsphäre entwickelt sich fließend mit, ohne allzu große tonale Unterschiede einzunehmen. Auf diesen Teppich der „Wärme“ trifft ein relativ digital klingender, mit einem zufällig generierten Arpeggiator gesteuerter Klang. Dias inkonsequente Muster des Arpeggiators erzeugt durch seine kurzen unregelmäßigen Klänge ein gewisses „Funkeln“, das den darunter liegenden Teppich schmückt und für die „Technik“ stehen soll, die das gesamte System am Laufen hält.

Die Klänge untermalen die Ströme des Systems bis zu Minute 01:30, wo das Herzstück des Verteilers gezeigt wird. Hier schwellen die Klänge noch einmal kräftig an und nehmen an Lautstärke zu, um die Kraft und Leistung des Verteilers zu zeigen.

Nach diesem letzten Höhepunkt der Komposition, nimmt sich die Musik zurück und wir sehen wieder die 2 Häuser nebeneinander stehen. Das Bild blendet langsam aus, bis es komplett dunkel ist und das Video damit endet.

Ausführung mit synthetischen Klängen

Das im Video vorgestellte Heiz- und Energiesystem hat bis auf den Fakt, dass es Temperaturen verändern und regulieren kann, relativ wenig bis garnichts mit der Natur zu tun, wenn man es als Maschine betrachtet. Demnach ist die Vertonung ebenfalls unnatürlichen Ursprungs. Die fließenden Pad Klänge, ergänzen die Visualisierungen des fließenden Stroms / der fließenden Wärme ohne sich dabei zu sehr aufzuspielen, die halten sich dezent im Hintergrund. Darüberhinaus sind die zufällig generierten Klänge des Arpeggiators eine angedachten Vertonung der Datenströme, welche dem System sagen wo es heizen, kühlen oder speichern soll. Es soll sozusagen ein digitaler Teppich aus zufällig gesetzten Impulsen entstehen die jedoch alle in der selben Tonart gespielt werden, um diese „Zufälligkeit“ durch eine Konstante auszugleichen.

Ausführung mit orchestralen Klängen

Der Großteil der Komposition besteht aus langanhaltenden, harmonisch klingenden Akkorden, die fließend ineinander übergehen. Dies lässt sich mit Streichern relativ gut umsetzen, da sie aufgrund ihres Ausdruckes und der variablen Lautheit (hier gesteuert durch 2 Midi Fader – Expression & Dynamics) sehr dynamisch klingen können. Auch das Frequenzspektrum wird von den jeweilig zugehörigen Instrumenten (zB. Viola – Cello – Bass) ausgefüllt, die sich im Klangbild somit zu einem vollen Klangteppich ergänzen, in welchem man die Instrumente trotzdem einzeln wahrnehmen kann.

Neben dem Klangteppich beinhaltet die Komposition jedoch auch noch ein zufällig generiertes Muster an Tönen, die immer wieder kurz auftreten und damit ein akustisches „Funkeln“ erzeugen, wenn man so will. Da dieser Effekt von einem Programm gesteuert wird, klingt er auf jeden Fall sehr ungewohnt, wenn man ihn mit Pizzicato Klängen von Streichern hört. Dennoch erzeugt es eine moderne Ästhetik, die die sonst sehr klassisch klingende Ausführung etwas neuer & innovativer klingen lässt.

Erkenntnisse

Das größte Erkenntnis dieser Komposition ist wohl, dass mehr nicht immer mehr ist. Wie schon Dieter Rahm in seinen 10 Regeln für gutes Design festlegte, ist gutes Design „as little as possible“. Auch wenn die Komposition noch einfacher sein hätte können, ist sie auf jeden Fall nicht zu aufdringlich und zu überheblich. Genau diese Einfachheit formt im Endeffekt den gewollten Effekt der Sicherheit, Expertise und Prestige des Projektes.

Bezogen auf die Instrumente ist das Stück in sowohl der einen, als auch der anderen Ausführung passend und fällt nicht zu sehr aus dem Bild. Dennoch vermittelt die Synthesizer Version in diesem Fall das Produkt besser, da es durch die synthetischen Klänge fortschrittlicher, neuer und innovativer klingt, als die orchestrale Version – die sich dennoch hören lassen kann.