Soziale Medien und Fake News gehen mittlerweile leider Hand in Hand. Viele Menschen lassen sich davon verwirren, werden verunsichert und zweifeln an ihren bisherigen Ansichten. Ein aktueller wissenschaftlicher Artikel zeigt, dass Falschinformationen mittlerweile mittels Künstlicher Intelligenz erkannt werden können. Wie das funktionieren soll, wird in diesem Blogpost erklärt.

Plattformen wie Instagram, Facebook oder TikTok sind schon lange kein vorübergehender Trend mehr, Social Media ist in längst in der Gesellschaft angekommen. Verständlich, denn sie haben auch viel Positives, ich persönlich bin ziemlich aktiv und poste regelmäßig auf Instagram. Grundsätzlich klingt zum Beispiel der Gedanke der freien Meinungsäußerung für alle durchaus positiv und vor allem sehr demokratisch.

Vor 15 Jahren hatten nur wenige Personengruppen, zum Beispiel Journalisten oder Politiker, die Möglichkeit, ihre Ansichten mit dieser Breitenwirksamkeit zu verbreiten. Nun kann jeder user mit seinem Post „viral“ gehen und von jetzt auf gleich tausende Menschen damit erreichen. Dieser Post wird dann hundertfach geteilt und kommentiert, am Ende weiß man oft nicht mehr, woher der Beitrag eigentlich kommt oder wer ihn überhaupt geschrieben hat. Der Algorithmus hinter den Sozialen Netzwerken erstellt je nach Nutzungsgewohnheiten ein genaues Interessensprofil jedes Users. Das Ziel ist es, die User möglichst lange auf der Plattform zu halten, um möglichst viel Werbung ausspielen zu können. Dafür wird jede Bewegung festgehalten: Alle Gefällt-Mir-Angaben, jeder Kommentar und sogar die Zeit, wie lange einzelne Beiträge betrachtet werden. Basierend auf diesen Informationen bekommen User exakt auf sie zugeschnittene Beiträge angezeigt, mit denen ihre Meinung meistens übereinstimmt. Das wiederum führt zu den bekannten Filterbubbles, Echo chambers oder wie auch immer man sie nennen mag. An sich auch noch in Ordnung, wenn man bedenkt, dass sich die Sozialen Medien ja irgendwie finanzieren müssen.

Problematisch wird es dann, wenn sich Falschinformationen verbreiten, sie sozusagen „viral“ gehen. Währen der Corona-Pandemie hat sich diese Problematik noch verstärkt, viele Menschen haben das Vertrauen in „Mainstream-Medien“ verloren. Sie glauben nichts mehr, was von Regierung oder Qualitätsmedien gesagt wird, sondern setzen auf dubiose Quellen, bei denen Herkunft und Motiv unklar sind. Es gibt Experimente, wo User extra auf diese Art von Inhalten geklickt haben. Danach wurden ihnen immer mehr davon angezeigt und innerhalb weniger Tage befanden sie sich in einer Desinformations-Bubble.

Was kann man dagegen tun?

Wichtig ist, Informationen kritisch zu hinterfragen. Dabei ist aber Information nicht gleich Information – wenn ich zum Beispiel etwas in der Zeit im Bild sehe, gehe ich davon aus, dass es stimmt. Stoße ich auf einen Facebook-Beitrag, prüfe ich natürlich kritischer, ob daran etwas nicht stimmen könnte.

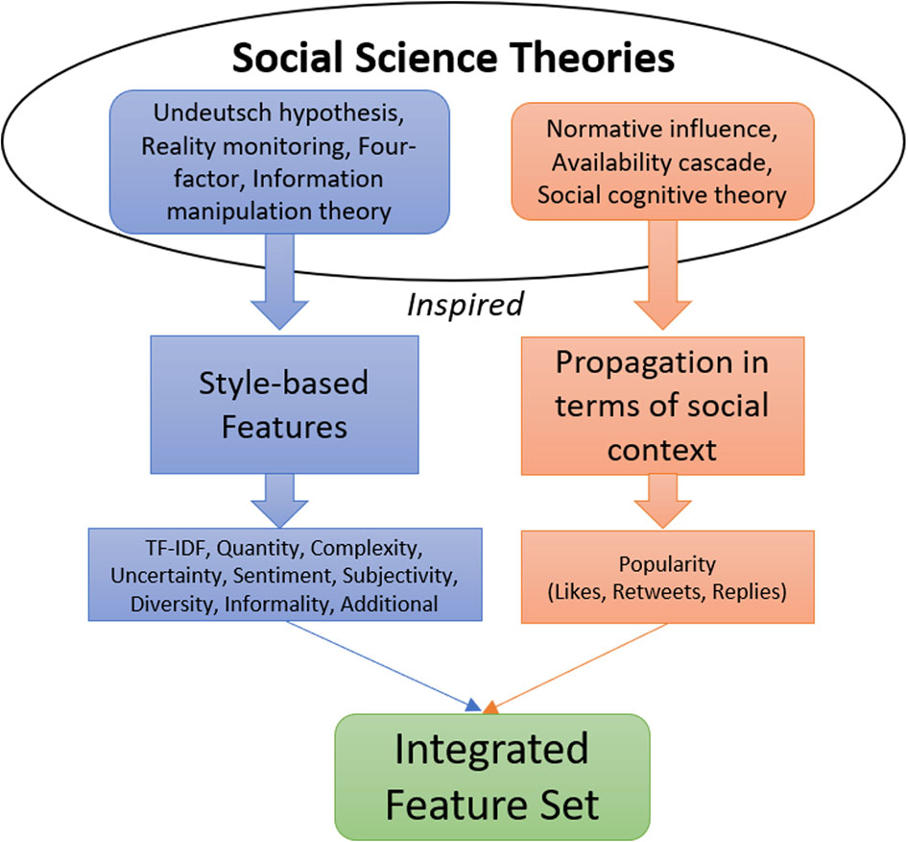

Im Rahmen einer anderen Lehrveranstaltung bin ich auf einen spannenden Artikel von Shubhangi Rastogi und Divya Bansal gestoßen. Die beiden schreiben, dass Falschinformationen mithilfe von Künstlicher Intelligenz entdeckt werden können. Genauer gesagt, lassen sich Beiträge in die Kategorien „echt“, „Falschinformation“ und „Satire“ unterteilen. Das funktioniert durch einen interdisziplinären Ansatz: Zum einen verwenden die Autoren von Fake News oft einen anderen Schreibstil, um ihr Publikum zu ködern. Es ist anscheinend möglich, die Absicht der Autoren festzustellen. Der Schreibstil alleine reicht allerdings noch nicht aus. Deshalb werden zusätzlich werden noch weitere 30 Faktoren miteinbezogen, die in Unterkategorien unterteil werden:

- Regelmäßigkeit

- Häufigkeit

- Schwierigkeitsgrad

- Unsicherheit

- Sentiment/Emotionalität

- Subjektivität

- Diversität

- Informalität

- Popularität

Die Autoren dieses Artikel nennen vier Aspekte des Fake News – Filterns: „Knowledge-based, Style-based, Propagation-based und Source-based“. Wissensbasierte Methoden nutzen klassische Fact-checks, um den Wahrheitsgehalt herauszufinden. Stilbasierte Methoden analysieren die Intention des Autors, zum Beispiel anhand der Emotionalität. Fake News – Beiträge verhalten sich anders als richtige Nachrichten – das lässt sich anhand ihrer Verbreitung feststellen. Fake News verbreiten sich schneller und werden populärer als Fakten. Zusätzlich wird ein Background-Check des Autors durchgeführt, um dessen Glaubwürdigkeit festzustellen.

Die Ergebnisse zeigen, dass diese Art der Fehlinformations-Filter einen Großteil der Beiträge richtig einordnen kann. Diese Studie wurde hauptsächlich auf Twitter durchgeführt, die Autoren planen allerdings, ihre Forschung auf andere Plattformen auszuweiten und am Ende einen automatischen, Domain-übergreifenden Fake News-Filter zu entwickeln.